tensorflow-十九弹

条评论话说在看论文的过程中看到了有很多神经网络的概念,不管什么学科都是建立在前人的基础之上的,所以了解一下现在相对来说比较古老的深度神经网络结构对我们充分理解深度学习,梳理学习过程是很有帮助的,因此这一讲我们着重了解一下各种其他类型的深度学习网络:

1.LeNet

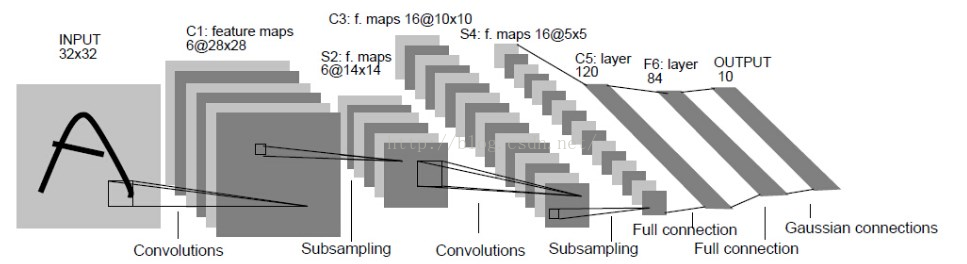

必须要将他列为经典,必学的网络结构之一,我们现在神经网络中很多特点都是由他开始的,主要设计与应用的目的在于对手写数字进行识别,其网络结构如图:

我们分析一下他的网络层:包括1.卷积;2.降采样;3.卷积;4.降采样;5权连接层;6.全连接层;不算输入与输出一共有6层,实际上现在看来LetNet网络的结构是十分简单的,但是他实现了一个卷积网络的所有结构.当然咯,实际上它只用了6种卷积核,和我们现在网络动则几十个卷积核比起来还是差得比较远,不过不要忘了,提出这个网络算法的时间是二十世纪,实际上忽略其深度上的差异,LeNet与我们现在所说的深度神经网络已经基本一致了.这个几乎是每一个想要学习深度学习的人入门所必学的吧.

参考资料:

1

2.AlexNet

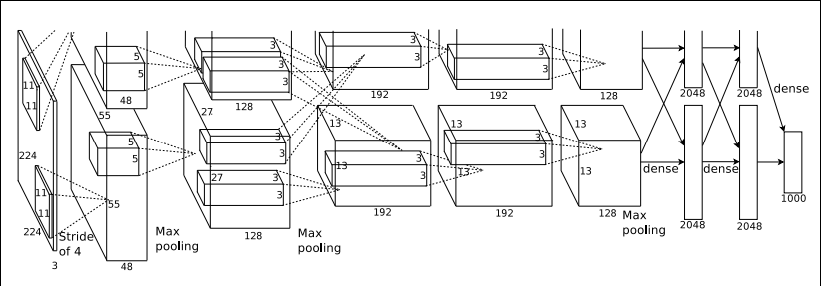

AlexNet的网络结构为: (图片来自网络侵删)

(图片来自网络侵删)

下面来详细分析一下过程,输入图像为224224大小,采用的滤波核为1111图上表示两台服务器,每一台服务器都提取48个特征,最终提取96个特征层,我们根据图示我们可以看到,给的stride为4,这个表示实际上间隔多少像素进行一次卷积操作,因此通过以上处理我们可以得到一个5555大小的影像,这样我们得到的特征变为555596,然后对计算结果进行ReLU映射,采用ReLU映射方式相比于sigmoid映射,能够在训练过程中更快的收敛,LRN函数进行局部区域归一化,局部区域归一化核大小为55,进行最大值池化,池化后影像大小变为2727,这样得到一个272796的输入影像进行第二次的卷积,这次采用的卷积核个数为256个,卷积过程为对每输入特征多个特征层相应区域进行卷积,然后求和,同样进行卷积ReLU映射,LRN处理,以及池化操作,处理后的结果作为第三层的输入,第三层使用384个1313的新特征图与第二层操作方式相同,然而第三层没有进行池化操作,第四层依旧使用384个1313的新特征图,与第三层的处理相同,没有进行池化操作,得到的结果作为第五层的输入,第五层采用256个1313的新特征图,进行处理,为了防止过拟合,进行了池化操作,最后得到256个6*6的特征图,第六层和第七层是全连接层,采用4096个神经元进行全连接操作,最后输出一个100维的输出结果.

从网络的结构来看可以看到,相比与LeNet网络AlexNet网络复杂了很多,通过多层特征网络的学习可以学习到各个目标物的特征,通过学习的特征进行全连接输出,实际上AlexNet在概念上有了一个特征学习的过程,对于未知输入不是直接对目标进行学习,而是对目标的特征进行学习,从而得到识别目标的特征.

参考资料:

1

2

3

4

3.GoogleNet

相信通过上面的介绍大家对各种深度网络都有很深刻的理解了,实际上虽然网络结构各有各的差别,但是网络的基础结构是存在相似性的,其元处理包括卷积,非线性映射,归一化,降采样等操作,而经典的不同网络设计之间有些微妙的差别需要做过才有体会,GoogleNet在这里就不进行详细的介绍了,网络上的资料已经很详细了,给出一些参考资料大家可以深度研究一下:参考资料